人工智能可以帮助快速总结研究。但它也伴随着风险。

当 Sam Rodriques 还是一名神经生物学研究生时,他对科学的一个根本局限性感到震惊。即使研究人员已经提供了了解人类细胞或大脑所需的所有信息,“我不确定我们是否会知道它,”他说,“因为没有人有能力理解或阅读所有文献并获得全面的视图。

五年后,Rodriques 表示,他离使用人工智能 (AI) 解决这个问题更近了一步。9 月,他和他在美国初创公司 FutureHouse 的团队宣布,他们构建的基于 AI 的系统可以在几分钟内生成比维基百科页面更准确的科学知识综合.该团队迅速为大约 17,000 个人类基因生成了维基百科风格的条目,其中大多数基因以前没有详细的页面。

Rodriques 并不是唯一一个转向 AI 来帮助综合科学的人。几十年来,学者们一直在努力加快将研究主体汇编成综述的繁重任务。“它们太长了,强度非常大,而且在写的时候往往已经过时了,”在伦敦国王学院研究综合研究的伊恩·马歇尔 (Iain Marshall) 说。人们对大型语言模型 (LLM) 的兴趣呈爆炸式增长,LLM 是 ChatGPT 等工具的基础生成式 AI 程序,这激发了人们对自动化任务的新兴奋。

一些较新的人工智能科学搜索引擎已经可以通过查找、排序和总结出版物来帮助人们制作叙述性文献综述——研究的书面导览。但是,他们自己还不能生成高质量的评论。最艰巨的挑战是 “黄金标准” 系统评价,它涉及严格的论文检索和评估程序,并且通常需要进行荟萃分析来综合结果。大多数研究人员都认为,这些距离完全自动化还有很长的路要走。“我相信我们最终会到达那里,”澳大利亚黄金海岸邦德大学(Bond University)的证据和系统评价专家保罗·格拉齐欧(Paul Glasziou)说。“我只是无法告诉你那是 10 年后还是 100 年后。”

然而,与此同时,研究人员担心人工智能工具可能会导致更草率、不准确或误导性的评论,从而污染文献。“令人担忧的是,几十年来关于如何进行良好证据综合的所有研究都开始受到破坏,”在伦敦大学学院研究证据综合的詹姆斯·托马斯 (James Thomas) 说。

计算机辅助审阅

几十年来,计算机软件一直在帮助研究人员搜索和解析研究文献。早在 LLM 出现之前,科学家们就已经使用机器学习和其他算法来帮助识别特定研究或从论文中快速提取结果。但是 ChatGPT 等系统的出现引发了人们对通过将 LLM 与其他软件相结合来加快这一过程的兴趣。

研究人员表示,要求 ChatGPT 或任何其他 AI 聊天机器人简单地从头开始撰写学术文献综述是非常天真的。这些 LLM 通过对大量写作进行训练来生成文本,但大多数商业 AI 公司不会透露这些模型是在哪些数据上训练的。Marshall 说,如果被要求审查关于某个主题的研究,像 ChatGPT 这样的 LLM 可能会利用可信的学术研究、不准确的博客以及谁知道什么其他信息。“不会权衡什么是最相关、最高质量的文学作品,”他说。而且由于 LLM 的工作原理是重复生成统计上合理的单词来响应查询,因此它们会对同一问题产生不同的答案并产生“幻觉”错误——包括臭名昭著的不存在的学术参考文献。“在研究综合中被视为良好实践的过程都没有发生,”Marshall 说。

一个更复杂的过程包括将预选论文的语料库上传到 LLM,并要求它从中提取见解,仅根据这些研究给出答案。这种“检索增强一代”似乎减少了幻觉,尽管它并不能阻止它们。还可以设置该过程,以便 LLM 引用其获取信息的来源。

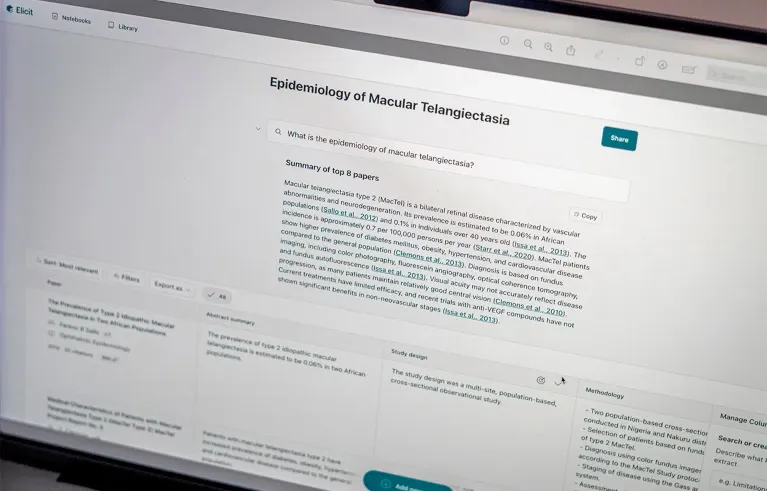

这是 Consensus 和 Licit 等专门的 AI 驱动的科学搜索引擎的基础。大多数公司不会透露其系统如何工作的确切细节。但它们通常会将用户的问题转化为跨学术数据库(如 Semantic Scholar 和 PubMed)的计算机搜索,从而返回最相关的结果。

然后,法学硕士总结了这些研究中的每一项,并将它们综合成一个引用其来源的答案;用户有各种选项来筛选他们想要包含的工作。“它们首先是搜索引擎,”新加坡管理大学(Singapore Management University)数据服务负责人、人工智能工具博客负责人郑亚伦(Aaron Tay)说。“至少,他们引用的内容绝对是真实的。”

这些工具“当然可以提高你的审稿和写作过程的效率”,南丹麦大学欧登塞分校的博士后研究员 Mushtaq Bilal 说,他用 AI 工具培训学者,并设计了自己的 Research Kick。例如,另一个名为 Scite 的 AI 系统可以快速生成支持或反驳主张的论文的详细分类。Elicit 和其他系统还可以从论文的不同部分提取见解——方法、结论等。Bilal 说,“你可以外包大量的劳动力”。

但 Bilal 说,大多数 AI 科学搜索引擎无法自主生成准确的文献综述。他们的输出更像是 “一个通宵达旦地想出几篇论文要点的本科生的水平”。他说,研究人员最好使用这些工具来优化审查过程的各个部分。Elicit 的工程主管 James Brady 表示,其用户正在增加审查步骤,“效果很好”。

一些工具(包括 Elicit)的另一个限制是它们只能搜索开放获取的论文和摘要,而不是文章的全文。(加利福尼亚州奥克兰的 Elicit 搜索了大约 1.25 亿篇论文;马萨诸塞州波士顿的 Consensus 调查显示,用户数量超过 2 亿。Bilal 指出,许多研究文献都是付费的,搜索大量全文需要大量的计算。“在数百万篇文章的全文中运行 AI 应用程序将花费大量时间,而且成本会高得令人望而却步,”他说。

全文搜索

对罗德里克斯来说,资金供应充足,因为加利福尼亚州旧金山的非营利组织 FutureHouse 得到了谷歌前首席执行官埃里克·施密特 (Eric Schmidt) 和其他资助者的支持。FutureHouse 成立于 2023 年,旨在使用 AI 自动化研究任务。

今年 9 月,Rodriques 和他的团队公布了 FutureHouse 的开源原型 AI 系统 PaperQA21.当收到查询时,PaperQA2 会搜索多个学术数据库的相关论文,并尝试访问开放获取和付费内容的全文。(Rodriques 说,该团队可以通过其成员的学术隶属关系访问许多付费论文。然后,系统识别并总结最相关的元素。他说,部分原因是 PaperQA2 会消化论文的全文,因此运行它的成本很高。

FutureHouse 团队通过使用该系统生成关于人类个体基因的维基百科风格的文章来测试该系统。然后,他们将这些文章中的数百篇 AI 撰写的陈述,以及来自同一主题的真实(人类撰写的)维基百科文章的陈述,提供给由博士和博士后生物学家组成的盲法小组。该小组发现,人工撰写的文章包含的“推理错误”是 AI 工具撰写的文章的两倍,其中书面声明没有得到引文的适当支持。由于该工具以这种方式胜过人类,因此该团队将其论文命名为“语言代理实现科学知识的超人综合”。

Tay 说,PaperQA2 和另一个名为 Undermind 的工具比传统搜索引擎需要更长的时间来返回结果——几分钟而不是几秒钟——因为它们会进行更复杂的搜索,例如,使用初始搜索结果来追踪其他引文和关键短语。“所有这些加起来计算成本非常高且速度缓慢,但提供了更高质量的搜索,”他说。

系统性挑战

文献的叙述性摘要已经很难制作了,但系统评价甚至更糟糕。它们可能需要数月甚至数年才能完成2.

根据 Glasziou 团队的细分,系统评价至少涉及 25 个仔细的步骤。梳理完文献后,研究人员必须过滤他们的候选名单以找到最相关的论文,然后提取数据,筛选研究是否存在潜在偏差并综合结果。(其中许多步骤由另一位研究人员一式两份完成,以检查是否存在不一致。例如,这种费力的方法——应该是严格、透明和可重复的——在医学上被认为是有价值的,因为临床医生利用结果来指导治疗患者的重要决策。

2019 年,在 ChatGPT 出现之前,Glasziou 和他的同事们着手实现科学世界纪录:在两周内进行系统评价。他和其他人,包括 Marshall 和 Thomas,已经开发了计算机工具来减少所涉及的时间。当时可用的软件菜单包括 RobotSearch,这是一种经过训练的机器学习模型,可以从一系列研究中快速识别随机试验。例如,另一个人工智能系统 RobotReviewer 有助于评估一项研究是否因为没有充分盲法而存在偏倚风险。“所有这些都是减少进行系统评价时间的重要小工具,”Glasziou 说。

时钟从 2019 年 1 月 21 日星期一上午 9:30 开始。该团队在 2 月 1 日星期五的午餐时间巡航过了线路,总共经过了 9 个工作日.“我很兴奋,”英国牛津大学的流行病学家 Anna Mae Scott 说,她在邦德大学期间领导了这项研究;每个人都用蛋糕庆祝。从那时起,该团队将其记录缩短到 5 天。

这个过程会变得更快吗?其他研究人员也一直在努力实现系统评价各个方面的自动化。2015 年,Glasziou 创立了国际系统评价自动化合作组织 (International Collaboration for the Automation of Systematic Reviews),这是一个利基社区,恰如其分地制作了几篇关于系统评价自动化工具的系统评价.但即便如此,“没有多少 [工具] 得到广泛接受”,Marshall 说。“这只是技术成熟程度的问题。”

Elicit 是一家表示其工具可以帮助研究人员进行系统评价的公司,而不仅仅是叙述性评价。Brady 说,该公司不会轻按一下按钮就提供系统评价,但其系统确实可以自动执行一些步骤,包括筛选论文和提取数据和见解。Brady 说,大多数使用它进行系统评价的研究人员都上传了他们使用其他搜索技术找到的相关论文。

系统综述爱好者担心,人工智能工具有可能无法满足研究的两个基本标准:透明度和可重复性。“如果我看不到使用的方法,那么它就不是系统综述,它只是一篇综述文章,”Justin Clark 说,他作为 Glasziou 团队的一员构建了审评自动化工具。Brady 说,审稿人上传到 Elicit 的论文是他们开始文献的“极好、透明的记录”。至于可重复性:“我们不能保证我们的结果在相同步骤的重复中总是相同的,但我们的目标是在合理范围内做到这一点,”他说,并补充说,随着公司改进其系统,透明度和可重复性将很重要。

综述专家表示,他们希望看到更多发表的关于人工智能系统准确性和可重复性的评估,这些评估旨在帮助产生文献综述。“构建很酷的工具并尝试一些东西真的很有趣,”Clark 说。“做一项硬核评估研究是一项艰苦的工作。”

今年早些时候,克拉克领导了一项系统综述,对使用生成式 AI 工具帮助进行系统综述的研究进行了综述。他和他的团队发现,只有 15 项已发表的研究将 AI 的性能与人的性能进行了充分的比较。尚未发表或同行评审的结果表明,这些人工智能系统可以从上传的研究中提取一些数据,并评估临床试验的偏倚风险。“它似乎在阅读和评估论文方面做得还不错,”克拉克说,“但它在所有其他任务上都做得非常糟糕”,包括设计和进行彻底的文献检索。(现有的计算机软件已经可以使用荟萃分析完成综合数据的最后一步。

Glasziou 和他的团队仍在尝试通过改进的工具来缩短审查记录的时间,这些工具可以在他们称为 Evidence Review Accelerator 的网站上找到。“这不会是什么大事。而是每年你都会变得越来越快,“Glasziou 预测道。例如,在 2022 年,该组织发布了一款名为 Methods Wizard 的计算机化工具,该工具向用户询问一系列有关其方法的问题,然后在不使用 AI 的情况下为他们编写协议。

匆忙的评论?

信息合成的自动化也存在风险。多年来,研究人员已经知道许多系统综述是多余的或质量差的,而 AI 可能会使这些问题变得更糟。作者可能会有意或无意地使用 AI 工具来快速浏览未遵循严格程序或包含低质量作品的评论,并获得误导性结果。

相比之下,Glasziou 说,AI 还可以鼓励研究人员快速检查以前发表的文献,而他们以前不会费心。“AI 可能会提升他们的游戏水平,”他说。Brady 说,未来,AI 工具可以通过寻找 P-hacking(一种数据纵形式)等迹象来帮助标记和过滤掉质量差的论文。

Glasziou 将这种情况视为两种力量的平衡:AI 工具可以帮助科学家制作高质量的评论,但也可能助长不合格评论的快速生成。“我不知道对已发表的文献的净影响会是什么,”他说。

有些人认为,综合和理解世界知识的能力不应该仅仅掌握在不透明的、盈利的公司手中。Clark 希望看到非营利组织构建并仔细测试 AI 工具。他和其他研究人员对两家英国资助者上个月宣布投资超过 7000 万美元用于证据合成系统表示欢迎。“我们只是想保持谨慎和小心,”克拉克说。“我们希望确保 [技术] 帮助我们提供的答案是正确的。”